|

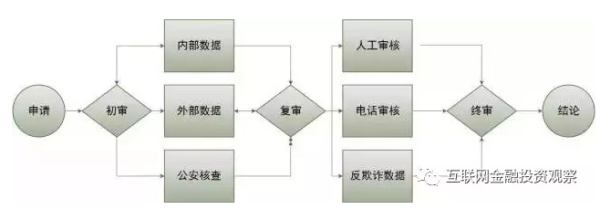

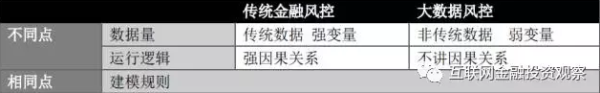

相对于传统风控,大数据风控在建模原理和方法论上并无本质区别,只不过是通过互联网的红利,采集到更多维的数据变量,通过分析数据的相关性来加强或者替代传统的强因果关系。 建模原理和方法论上并无本质区别大数据风控即大数据风险控制,是指通过运用大数据构建模型的方法对借款人进行风险控制和风险提示。 要理解大数据风控,首先要把传统金融风控搞清楚。这里以银行的信用卡部门为例, 解析一下传统银行的信用审批流程。(附图综合了几家银行信用卡中心的审核流程)

信用卡审核简易流程图 从流程上看,银行的信用审核,是以风控评分卡模型的自动审核为主,以人工审核为辅的模式,在需要特定审核的环节由人工进行,比如验证你的工作、校验你联系人的真实性等。这也是为什么在现实生活中一部分人在信用卡申请过程中会收到人工审核电话,一部分人并不需要该验证环节即可获得信用卡。 从审核数据上看,对于银行来说,影响审批额度的主要因素包括客户基本特征(包括男女、年龄、教育程度等等)、客户的风险暴露情况(社会收入、债务情况、还债能力综合评估)、现有的社会表现(房贷还款情况、其他银行信用卡使用情况等)。 不管是中资还是外资银行,大致都遵循了这样一套风险评估和信用审核的逻辑。对比之下,就可以看出,时下互联网金融鼓吹的大数据风控在原理和方法论上跟传统金融的风险控制并没有本质区别。 市场空白给予机会 以数据相关性替代因果关系大数据风控相对于传统风控来说,建模方式和原理其实是一样的,其核心是侧重在利用更多维的数据,更多互联网的足迹,更多传统金融没有触及到的数据。 比如电商的网页浏览、客户在app的行为轨迹、甚至GPS的位置信息等,这些信息看似和一个客户是否可能违约没有直接关系,但实则通过大量的数据累积,能够产生出非常有效的识别客户的能力。

大数据风控与传统银行风控的比较 数据量大是大数据风控一直宣传的活字招牌,至于多少的数据量级才能算得上大,业内一直没有统一或者较为通用的标准。 根据公开资料,蚂蚁金服的风控核心CTU 投入了2200多台服务器,专门用于风险的检测、分析和处置。新华网的报道显示,蚂蚁金服每天处理2亿条数据,数据维度有10万多个。京东金融2016年6月,投资了美国的大数据公司ZestFinance,之后还与其联合发起成立了合资公司ZRobot。ZRobot主要定位在为互金企业提供数据建模、信用评分、资产定价、欺诈识别等服务。京东金融依靠中国最大的电商-京东的数据量,在国内已算大数据拥有者。 聚秀资本合伙人江南愤青表示,按照惠普副总裁提及的大数据概念,全球有能力进行所谓的大数据应用的公司不超过50家。大量的公司只是在做数据的优化,根本不能称之为大数据风控。 在数据维度这个层级,传统金融风控和大数据风控还有一个显著的区别在于传统金融数据和非传统金融数据的应用。传统的金融数据包括我们上文中提及的个人社会特征、收入、借贷情况等等。而互金公司的大数据风控,采纳了大量的非传统金融数据。比如阿里巴巴的网购记录,京东的消费记录等等。 在运行逻辑上,不强调强因果关系,看重统计学上的相关性是大数据风控区别于传统金融风控的典型特征。传统金融机构强调因果,讲究两个变量之间必须存在逻辑上能够讲通因果。一位不愿具名的前城商行信用卡中心负责人表示,在银行的信用评审中,他们即便发现了一些非传统变量在统计上看来跟审核结果存在某种相关性,如果不能够在逻辑上讲通,他们也断然不会采用。 “比如我们发现在某个时间点来申请的客户,从后期数据表现上来看逾期的概率就是比较高。但如果没办法从逻辑上解释通其中的道理,我们是不会贸然把它作为因变量放在审核模型当中去的。” 但与传统金融机构不同,互金机构的大数据风控吸收的正是大量的潜在相关性数据。为何说是潜在?因为通过互联网的方式抓取大量数据之后,一定会有一个数据分析和筛选的过程,在这个过程中,大量数据会被证明不相关直接被踢掉。留下的相关性数据才会被运用到风险审核当中去。 传统的线下小贷公司在放贷过程中,会有一些自己的经验判断,在面对一些特定行为特征、生活习惯的客户会首先有一个自己的直观打分判断,这些是长期经验累积的结果。现在一些互金公司可以通过技术化的手段把这些也变成输入变量纳入到风控审核当中去。 大数据风控需要纳入非传统变量,将风控审核的因果关系放宽到相关关系是有其业务原因的。伴随着互联网金融的火热,大数据风控逐渐升温。中国的互联网金融,服务的客群简言之可以分为两类:无信贷历史记录者和差信贷历史记录者。而这两部分人群,恰恰是中国传统金融机构没有服务到的两部分人群。 这两部分人群包括中国的学生、蓝领、以及一部分的白领等。这部分客群,在央行没有征信报告,几乎没有过往金融服务记录,照搬传统金融的风险审核会出现水土不服的状况。 对传统金融机构而已,在对一个客户进行信用风险评估时,工作单位是强变量。这直接关系到他的社保记录。但对一个没有固定工作的客户来讲,工作单位就变成了一个弱变量,对于最后的风控审核助力有限。 同理,学历、居住地、借贷记录这些传统的强金融风控指标可能在面对无信贷记录者和差信贷记录者时都会面临同样的问题。这迫使互金公司需要通过其他方式补充新的风控数据来源,并且验证这些数据的有效性。 场景厮杀激烈 大数据风控有效性有待验证相对于传统金融机构,互金公司扩大了非传统数据获取的途径,对于新客户群体的风险定价,是一种风险数据的补充。但这些数据的金融属性有多强,仍然有待验证。 而数据的金融属性取决于如何去挖掘,如京东电商上购物记录其实是目标客群很好的刻画,送货的地址,GPS经常驻留的地址等,是一个人的居住地的概率很大。在这一点上,腾讯的微众银行、京东金融,蚂蚁金服等互联网巨头手中都掌握着海量的数据。

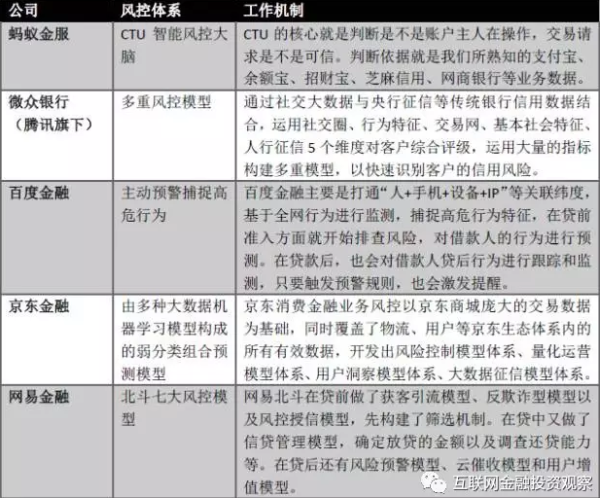

各大公司的风控体系 来源:根据网络公开资料整理 根据《证券日报》报道,微众银行旗下微粒贷的单笔均借款金额低于1万元,逾期率低于0.3%。“微众可以拿到腾讯的数据,这是其他所有公司没发比的,在小额借贷领域,他们的优势太明显了。”前述不愿具名人士透露。 巨头优势明显,但大公司不可能面面俱到,布局下各种场景。并不代表创业公司的路已被堵死。在互联网巨头尚未涉及的领域,小步快跑,比巨头更早的抢下赛道,拿到数据,并且优化自己的数据应用能力,成为创业公司杀出重围的一条路径。 有一个稳定的场景,能够在自然状态下真实地采集到客户行为所展现的数据,这是大数据风控的前提。在一些尚未被巨头嗅到的场景领域,竞争厮杀已经非常激烈。 农分期、会分期、房司令、租房宝、蜡笔分期、学好贷、爱旅行、趣分期、分期乐、买单侠、优分期·······农业、租房、蓝领、学生、旅游等各个场景和不同人群下的争夺已经日趋白热化。 陆金所CEO计葵生在2016年的中国支付清算与互联网金融论坛上自曝陆金所的年华坏账率在5%——6%。并且,根据腾讯财经的报道,计葵生指出,如果风控做不好,P2P的行业坏账率将远超10%。根据新经济100人的报道,学生分期起家的分期乐坏账率低于1%。银监会数据显示,2016年第三季度,我国大型商业银行的不良贷款率为1.67%。 而在今年11月,《21世纪经济报道》披露的苏宁消费金融公司的贷款不良率高达10.37%。该文章指出,苏宁内部人士透露,10.37%的坏账绝对不是行业最高的,很多面向大学生提供分期消费的平台,不良率超过25%。 坏账率、不良率、逾期率,各种不同的指标计算口径不同,结果大相径庭。缺乏统一的行业标准,野蛮生长下也不乏充斥着故意夸大和谎言之嫌。互金行业的坏账像一个披着面纱的女郎,始终不得其真容。 不同客群的坏账表现有其梯度差异,但是良好的数据获取和数据应用能力可能会在一定程度上优化数字表现,成为企业的一道有力护城河,这也是留给创业公司的一个机会。 国内的大数据风控困境首先是中国征信体系的不完善。要知道大数据风控的第一步就是获取数据。波士顿咨询的报告显示,央行个人征信记录覆盖率仅仅为35%。而互金企业的目标用户也多为信用卡无法触达的人群,可想而知,这批人就更没有什么信用记录可言了。而各家消费金融公司的数据相互分享可能性很小。现在大多数公司的做法是将自己的数据共享给第三方征信机构,再从征信机构那里获取数据,但这种数据的有效性存疑。获取有用数据或许成为很多公司构建自己的大数据风控模型的第一个难题。 其次是中国的团体欺诈现象。前Capital One高管,现任趣店CRO的粘旻环女士就表示,“目前国内的信用市场,反欺诈仍然是头号难题”。在中国,这种欺诈套现早已做成了一个产业链,从中介公司到商家甚至是自家公司的销售,沆瀣一气。通过各种方式召集法律意识淡薄的用户来进行借贷,再将借到的钱瓜分。而诈骗分子跑路后,还款以及逾期都压到了用户的头上。 然而前来申请借款的用户用的都是真实的信息,平台给用户的额度也在合理的范围内,这样的诈骗方式让平台处于很被动的处境。现在的处理方式只能是发现一起就抓一起,发生之后处理的速度是关键。不过粘旻环女士也表示之后会采用更主动的方式来防御。“目前,我们在搜集我们自己和同行们遇到的相关案例,寻找这部分容易被利用的人群身上的共性。在有足够的样本以后,我们可以梳理出这些用户的画像,并建立相关的风控模型。” 第三个难题就是金融行业频发的“黑天鹅”事件。如今大数据被吹的神乎其神的一个重要原因就是认为它可以有效地推演及预测未来。但是立足于统计学基础之上的大数据可以预测出跳出规则之外的黑天鹅事件吗?恐怕很难。在国内大数据风控的发展仅仅经历了几年的时间,在这期间中国还未发生过类似2008年美国次贷危机的大规模金融危机。因此,国内大部分公司构建的大数据风控体系没有经历过极端经济环境的压力测试,届时可能完全失灵。 做风控审核,其实是审人,人性的展现,大数据模型虽然讲究的是大和相关性,但用于金融的风控,有些前提是必要的: 1 这些个大数据必须是客户自然行为的流露和展现,这样才能避免逆向选择,数据才有效。 2 采集的过程稳定,可持续,这样才长久。 3 数据够一定厚度,才能真正起到作用。 现在的阿里腾讯京东做金融大数据风控都有如上一些特点。 |